Mener un projet d’IA contributif : enseignements et méthodologies

Comment le projet PIAF explore les enjeux de la contribution et des communautés

Le projet PIAF “Pour des intelligences artificielles francophones” a pour objectif de construire le premier jeu de données ouvert de questions-réponses en français. La cible : permettre à des services qui utilisent l’IA (et plus spécifiquement le traitement automatique du langage) d’améliorer leur performance grâce à des données d’entraînement en français et de qualité.

Lancé en juin 2019, ce projet a été mené par une petite équipe au sein d’Etalab, plus précisément du Lab IA, dont la mission est de diffuser des méthodes et des ressources pour l’IA publique. Pendant 6 mois, l’équipe a défini sa méthodologie et un axe a été rapidement privilégié : faire de PIAF un projet contributif, qui permette autant de diversifier les participants au projet (ie : ne pas uniquement en faire un projet technique) que de constituer une communauté autour des sujets d’IA et d’open data.

Qu’avons-nous appris de cette expérience ? Quelles sont les principales difficultés auxquelles nous avons été confrontés ? Quelles ont été nos surprises ? Nous vous proposons, dans cet article, un retour d’expérience qui pourra être utile à d’autres équipes.

Un projet technique, une approche moins technique

Lorsque nous avons décidé de nous aventurer dans l’univers des jeux de données francophones, le sujet nous paraissait assez complexe techniquement : au sein de l’administration, de plus en plus de projets d’IA sont menés (grâce notamment au programme Entrepreneurs d’intérêt général et aux appels à manifestation d’intérêt IA), mais le vocabulaire de l’IA n’est pas encore pleinement installé. Les termes comme traitement automatique du langage, données d’entraînement, plateforme d’annotation, “leader-board”, “speech to text”, etc. ne se retrouvent pas tous les 2 jours dans le journal officiel ! Parfois même, on emploie des termes de l’IA avec quelques contre-sens et une maîtrise limitée.

Pour palier le risque d’un projet trop technique et uniquement tourné vers la communauté data science, nous avons pris le parti de faire de PIAF un “prétexte” pour parler de l’IA autrement au sein de l’administration.

Cette approche non technique était doublement importante pour PIAF :

- en présentant les usages et impacts attendus d’un jeu de données de questions-réponses en français (à savoir : des services publics qui mobilisent l’IA plus performants car entraînés sur des données natives en français et une forme de souveraineté numérique), nous prouvons tout l’intérêt du projet pour le service public et avons ainsi l’adhésion des futurs bénéficiaires du projet ;

- en abordant le sujet de l’IA avec une vision moins techno-centrée, nous permettons à des publics nouveaux de s’approprier les termes de l’IA.

Pour nous inspirer, nous avons fait appel à plusieurs groupes de spécialistes, pour qu’ils nous conseillent et nous suivent. Deux rencontres ont été particulièrement enrichissantes :

- Les équipes de Common Voice, qui nous ont raconté la genèse de ce projet de données vocales ouvertes. Leurs conseils : rendre le projet intelligible, disposer d’une plateforme d’annotation simple d’utilisation et fédérer la communauté en ligne et en présentiel ;

- Nous échangeons régulièrement avec des chercheurs en humanités numériques pour aborder les questions, notamment éthiques, que pose l’engagement des contributeurs dans un projet technologique porté par une administration d’État, et explorer le rôle d’un tel objet technique dans la ligne d’horizon technologique portée par le Lab IA.

Une méthodologie contributive calibrée et orientée vers les objectifs de PIAF

Ces échanges et notre expérience des formats participatifs mis en place par Etalab depuis plusieurs années (hackathons, Forums Open d’Etat, consultations, open lab) nous ont menés vers la définition d’une “palette” de formats pour que PIAF soit un projet ouvert dans toutes ses dimensions.

Les volets stratégique et scientifique : Open Labs et échanges avec la communauté scientifique

-

Les Open Labs : afin de tenir informée une diversité de parties prenantes sur un projet, au lieu d’organiser des “comités de pilotage”, nous avons préféré un format plus ouvert, les open labs. Le principe : chaque trimestre, réunir les contributeurs et personnes intéressés pour faire le point sur le projet dans son ensemble (avancées, problèmes, opportunités).

-

Les échanges pair-à-pair avec des communautés plus techniques. Par exemple, nous avons présenté PIAF à l’équipe ALMAnaCH d’Inria qui a élaboré le modèle CamemBERT (voir notre article sur le sujet). Le lien avec la communauté scientifique nous a permis de conforter nos hypothèses et d’imaginer des collaborations futures.

Les volets participatif et pédagogique : annotathons, tournées

-

Une liste de diffusion : lors du lancement du projet, nous avons ouvert une liste de diffusion, qui s’est enrichie au fil des semaines, des événements et des rencontres.

-

Les “annotathons” : chaque semaine, nous réunissons tout contributeur volontaire et/ou intéressé par le projet au Lieu de la transformation publique (merci la DITP). En 4 mois (octobre-janvier), nous avons organisé 12 annotathons et réuni plus de 150 personnes. Lors de ces moments contributifs, animés par Benjamin, notre chargé de déploiement, les contributeurs “s’embarquent” dans le projet, en créant un compte et en réalisant une première annotation. Des échanges ont lieu sur le projet, l’expérience utilisateur et de nouvelles annotations sont réalisées.

Ces événements nous ont permis, au fil de l’eau : - d’apporter des améliorations UX sur la plateforme d’annotation - d’affiner notre discours sur le projet - d’identifier des cas d’usages et des partenariats avec des administrations

- Les tournées : grâce aux annotathons et à nos échanges avec les administrations sur l’IA, nous avons été sollicités par plus de 5 ministères pour présenter PIAF à différents publics. Ces événements étaient l’occasion de faire parler du projet tout en proposant des formats pédagogiques sur l’IA.

En complément, nous avions en tête qu’un travail éditorial était nécessaire pour faire vivre le projet et le documenter. Nous avons donc fourni un effort supplémentaire pour disposer d’un site attractif et écrire du contenu au fil de l’eau. Et bien sûr, tout au long du projet, nous nous attachons à tout ouvrir (la méthode comme le code). D’autres actions sont en réflexion : créer une identité de PIAF sur les réseaux sociaux, ouvrir un forum de discussion en ligne, etc.

Les frontières de la contribution volontaire

Vous l’aurez compris, PIAF c’est d’abord générer des questions-réponses en français de manière contributive. Pour cela, nous avons mis en place une plateforme d’annotation qui permette à tout contributeur de proposer des questions et des réponses sur un texte.

Pendant les 4 premiers mois d’annotation (octobre 2019-janvier 2020), notre cible était d’atteindre 20 000 questions-réponses pour constituer un premier jeu de données d’évaluation, afin d’évaluer la performance de modèles sur un jeu de données nativement en français. Les annotathons ont été mis en place pour atteindre cet objectif et répondre à une exigence de qualité : ces premières données devaient être produites par des “annotateurs certifiés”, c’est-à-dire formés par l’équipe.

Vous l’aurez compris aussi, nous avions plusieurs options pour générer ces questions-réponses :

- faire appel à une plateforme de microtravail pour les générer (comme par exemple Amazon Mechanical Turk) ;

- recruter des annotateurs dans nos équipes ;

- proposer des contributeurs volontaires.

Nous avons fait le choix d’explorer l’option de la contribution volontaire. Cette option suppose de se poser la question de la motivation et l’engagement des contributeurs. Cette question est d’autant plus difficile qu’à la différence d’autres projets contributifs comme OpenStreetMap ou Wikipédia, les usages d’un tel jeu de données ne sont pas directs et dépendent des algorithmes qui pourront être entraînés sur les données collectées.

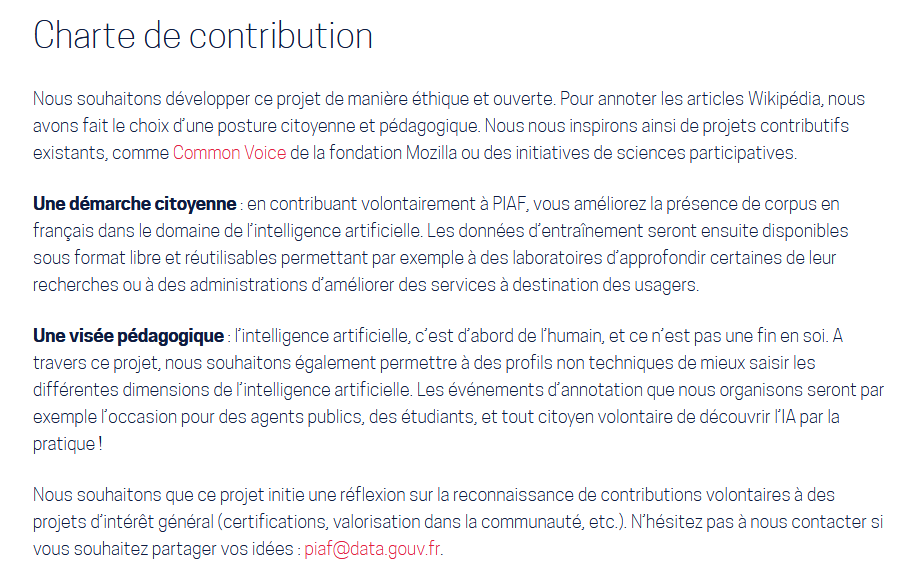

Pour relever ce défi et explorer cette option dans la pratique, les annotathons que nous avons organisés avec les agents publics comportaient une dimension pédagogique importante : en venant à un annotathon, un agent public acquiert des connaissances sur ce qu’est l’IA, le traitement automatique du langage, les usages des questions-réponses pour les services publics. Par ailleurs, pour que le contrat avec les contributeurs soit clair, nous avons rendu publique une charte de contribution(voir capture d’écran ci-dessous) et nos CGU explicitent les bornes du projet.

En 4 mois, nous avons atteint près de 5 000 contributions sur les premières 20 000 cibles.

Pourquoi cette performance ? Plusieurs explications :

- Nous avons sous-estimé la difficulté de la “tâche” d’annotation : lire un paragraphe d’un texte Wikipédia puis poser des questions et des réponses dessus est complexe, surtout lorsque le contributeur ne choisit pas le texte qu’il annote ;

- Une fois qu’une personne est venue à un annotathon, elle revient rarement les semaines suivantes, et elle annote rarement en dehors de ces temps collectifs ;

- Notre plateforme n’était pas assez robuste et auto-porteuse pour être directement diffusée auprès du grand public. Maintenant c’est le cas !

Cela étant dit, si l’on rapporte les 5 000 questions-réponses aux 350 contributeurs, le résultats est plutôt encourageant !

Ce bilan est utile car il confirme certaines hypothèses (et inquiétudes) que nous avions exprimées au démarrage du projet.

- La première étant celle qu’un projet d’une telle complexité - mais avec un potentiel énorme pour la francophonie - nécessite davantage d’investissement dans l’animation de communautés et le déploiement.

- La deuxième hypothèse est celle liée au design : plus une plateforme est simple d’utilisation et raconte clairement les objectifs d’un projet, plus il est simple de diversifier et d’amplifier les contributions.

- La troisième est celle liée à l’engagement : les contributeurs doivent avoir une certaine visibilté sur ce à quoi ils contribuent. Le fait de construire un jeu de données francophones “souverain” ne suffit pas, il faut que les usages soient mieux et plus directement identifiables.

C’est pourquoi plusieurs prochaines étapes nous attendent :

- Ouvrir les données collectées et tester les premières données sur des cas d’usages de l’administration : nous avons quelques pistes (voir notre article sur les cas d’usages). Par ailleurs, nous avons pris la décision de ne pas réaliser de “leader board” (laisser une partie des données fermées afin de comparer la performance de différents modèles sur des données non utilisées à l’entraînement) et d’ouvrir toutes les données collectées

- Amplifier le nombre de questions-réponses : après des analyses du premier jeu de données (5000 questions-réponses), nous avons évalué avoir besoin de 20 000 questions-réponses pour le jeu d’entraînement (au lieu des 100 000 au démarrage du projet).

- Identifier les nouveaux “PIAF” du Lab IA : ce projet nous a permis de confirmer que la communauté IA exprimait le besoin de disposer d’autres types de données ouvertes et francophones pour l’IA

Pour résumer, quelques conseils pour mener un projet d’IA (ou autre) de manière ouverte et contributive :

- Demander conseil à des personnes qui ont déjà fait ces expériences

- Echanger collectivement sur les enjeux éthiques (et les rendre visibles)

- Mobiliser une équipe à plein temps sur l’animation de la communauté et le déploiement : nous avons appris qu’il n’était pas possible d’avoir uniquement un développeur, un chargé de développement, et un coach à mi-temps. Il faut une équipe en permanence pour répondre aux besoins des utilisateurs d’un projet participatif.

- Documenter le projet en continu

- Tester la méthode de contribution et accepter de la changer si celle que vous avez choisi ne trouve pas son “économie”

Vous avez un avis ? Des idées ? Vous voulez tester PIAF ? -> Vous pouvez désormais utiliser notre outil open-source github.com/etalab/piaf.

-> Vous pouvez également nous écrire : piaf@data.gouv.fr